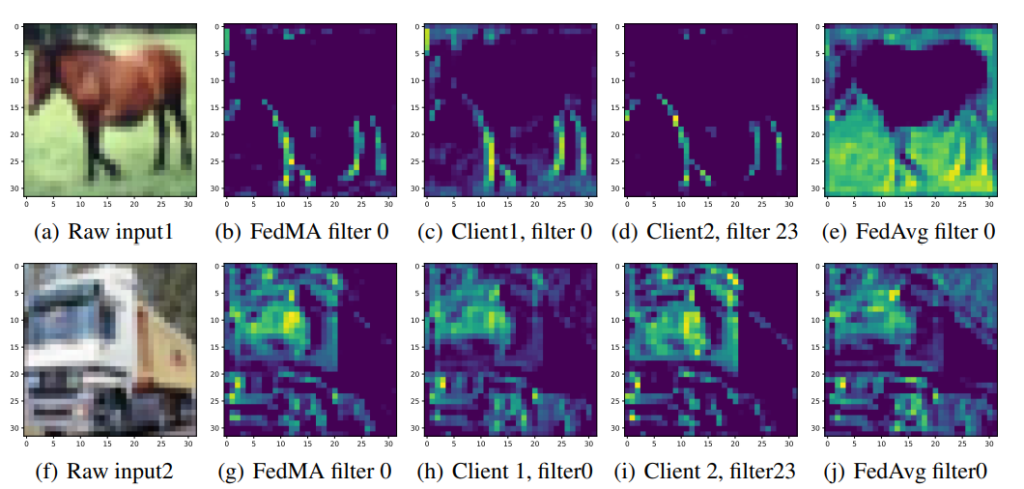

저번 화요일에는 이훈희 연구원이 연합학습에서의 가중치를 일반적인 federated averaging 했을 때 생기는 근본적인 문제점인 가중치 붕괴 문제를 파악하고 이 문제를 해결하기 위한 방법을 제안하는 논문을 발표했습니다. 이 논문에서는 은닉 계층이 가지는 가중치 행렬 사이의 유클리드 거리를 계산한 후 이 유클리드 거리가 유사한 은닉 계층끼리 같이 hungarian algorithm을 통해 묶어서 가중치가 붕괴하여 담고 있는 정보를 잃어버리는 것을 방지하고 높은 학습 성능을 유지하도록 하고 있습니다. 이 기법을 통해 federated learning에서 좋은 학습 성능을 유지하는 것을 저자들은 다양한 실험을 통해 보였습니다. 하지만 논문에서 거의 대부분의 고급 신경망 모델에서 쓰이는 batch normalization에 대해서는 적용할 수 없다고 밝힌 것은 이 방법이 적용 범위를 많이 제한하는 것 같아 좀 아쉬웠습니다.