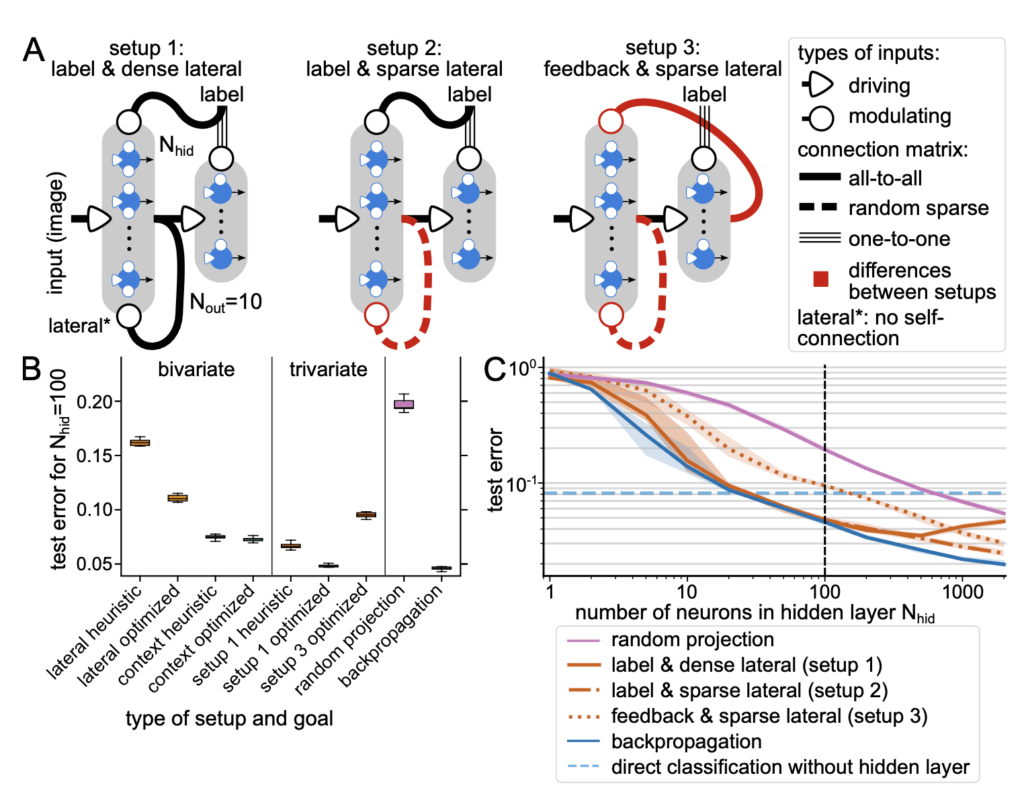

이번주 월요일에는 탁동혁 연구원이 인공신경망에서 네트워크 단위의 학습이 아닌 실제 뉴런 단위의 학습은 어떻게 이뤄지고 뉴런 각 객체가 헤비안 룰과 비슷한 방식 및 lateral inhibition을 이용해 학습을 진행할 때 기존의 학습 방식인 back-propagation과 어떤 차이가 있는지 깊게 분석한 논문을 가져왔습니다. 이 논문에서 제안하는 뉴런은 정보 엔트로피의 개념을 차용하여 상대적으로 학습에 있어서 중요도가 높은 정보들을 우선적으로 학습할 수 있도록 목적함수를 만들었으며 이 목적 함수로부터 나온 값을 이용해 gradient ascent 방식으로 신경망의 파라미터들을 최적화 하였습니다. 이를 통해 기존의 back-propagation과 gradient descnet를 사용한 방식과 비슷한 신경망 성능을 얻을 수 있었습니다. 하지만 아직은 이 뉴런을 개념적으로 최초로 정의하고 구현하여 사용한 것이기 때문에 practicality가 약간 떨어져 보이는 것이 단점인 것 같습니다.