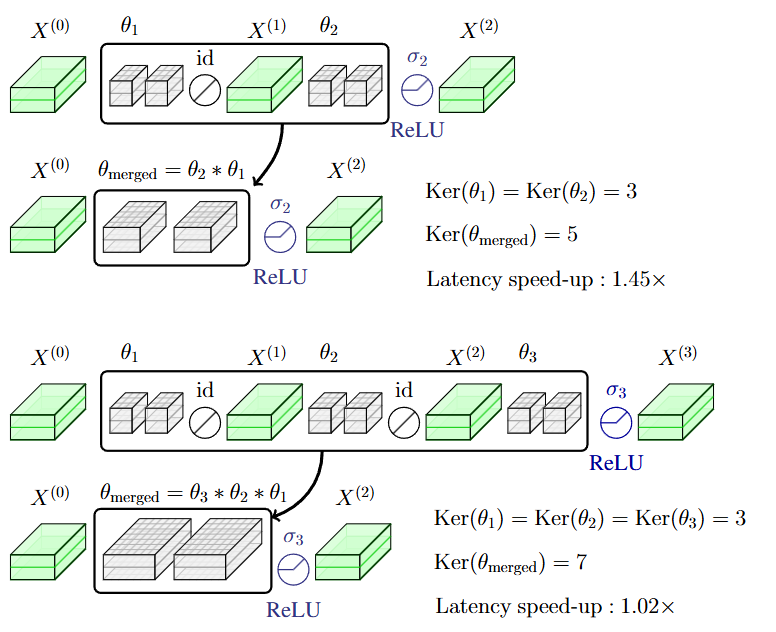

이번주 화요일에는 허정윤 연구원이 신경망을 압축하여 크기는 줄이면서도 최대한 성능을 보존할 수 있는 방법을 소개하는 논문을 발표했습니다. 이 논문에서는 신경망에 존재하는 여러 layer들을 묶어서 압축하거나 제거하고 압축 및 제거를 통해 만들어진 구조들을 LUT로 만들어서 저장한 뒤 이를 inference 단계에서 사용할 수 있도록 한 전략을 소개하고 있습니다. 해당 방법을 통해 저자들은 실제 깊은 신경망 구조에서 layer들의 개수는 많이 줄이면서도 inference의 정확도는 많이 낮추는 결과를 보였습니다. 하지만 정형화된 알고리즘이나 수식에 기반하여 동적으로 움직이는 네트워크 구조 대신에 단순 LUT로 네트워크들을 다 저장하거나 혹은 네트워크의 구성에 대한 설정을 다 저장해야 한다는 점은 조금 비효율적으로 보였습니다.